2024-12-03

Estimated reading time: 6 minutes

Questa guida ti mostrerà come configurare e utilizzare facilmente i modelli linguistici di grandi dimensioni (LLM) localmente utilizzando Ollama e Open WebUI su Windows, Linux o macOS, senza bisogno di Docker. Ollama offre l'inferenza dei modelli localmente, mentre Open WebUI è un'interfaccia utente che semplifica l'interazione con questi modelli. L'esperienza è simile a quella offerta da interfacce come ChatGPT, Google Gemini o Claude AI.

Eseguire Open WebUI senza Docker consente di utilizzare le risorse del computer in modo più efficiente. Senza le limitazioni degli ambienti containerizzati, tutta la memoria di sistema disponibile, la potenza della CPU e lo spazio di archiviazione possono essere completamente dedicati all'esecuzione dell'applicazione. Questo è particolarmente importante quando si lavora con modelli che richiedono molte risorse, dove ogni bit di prestazioni è cruciale.

Ad esempio, se utilizzi Open WebUI per interagire con modelli linguistici di grandi dimensioni, l'esecuzione nativa può comportare tempi di elaborazione più rapidi e prestazioni più fluide, poiché non vi è alcun overhead dovuto alla gestione del container da parte di Docker. Eseguendo l'applicazione in modo nativo, si ottengono anche:

Prima di iniziare, assicurati di avere installato i seguenti elementi sul tuo sistema:

Assicurati di utilizzare Python 3.11.X. Ad esempio, la versione 3.11.6 funziona bene. L'ultima versione di Python, 3.12.7, non è compatibile con la versione attuale di Open WebUI.

Puoi scaricare Python qui. Assicurati di selezionare la versione appropriata per il tuo sistema operativo. Python è un linguaggio di programmazione versatile, ampiamente utilizzato in AI e machine learning, inclusi lo sviluppo e l'operatività dei modelli linguistici di grandi dimensioni (LLM). Se vuoi migliorare le tue competenze in quest'area, consulta i nostri flashcard Python per un modo rapido ed efficiente per imparare.

Per installare Open WebUI, puoi utilizzare il gestore di pacchetti pip di Python. Segui questi passaggi:

Apri il terminale ed esegui il seguente comando per installare Open WebUI:

pip install open-webuiDopo l'installazione, aggiorna pip all'ultima versione eseguendo:

python.exe -m pip install --upgrade pipUna volta installato Open WebUI, avvia il server con il comando seguente:

open-webui serveDopo aver avviato correttamente Open WebUI, puoi accedervi nel browser all'indirizzo: http://localhost:8080.

In alternativa, se preferisci, puoi installare Open WebUI clonando direttamente il progetto da GitHub. Per maggiori dettagli, consulta la sezione alla fine di questa guida.

Per impostazione predefinita, Ollama utilizza i seguenti percorsi per archiviare i modelli linguistici (LLM) sul tuo sistema:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsPuoi modificare questo percorso se necessario. Ad esempio, su Windows, utilizza il seguente comando:

setx OLLAMA_MODELS "D:\ollama_models"Se esegui Ollama come applicazione macOS, le variabili di ambiente devono essere impostate utilizzando launchctl. Per impostare una variabile, utilizza il seguente comando:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Dopo aver impostato la variabile, riavvia l'applicazione Ollama affinché le modifiche abbiano effetto.

Per gli utenti Linux che eseguono Ollama come servizio systemd, è possibile impostare le variabili di ambiente utilizzando systemctl. Ecco come fare:

Apri la configurazione del servizio eseguendo:

sudo systemctl edit ollama.serviceSotto la sezione [Service], aggiungi la seguente riga:

Environment="OLLAMA_MODELS=/new/path/to/models"Salva il file, quindi ricarica systemd e riavvia il servizio:

sudo systemctl daemon-reload

sudo systemctl restart ollamaPer scaricare ed eseguire i modelli linguistici in Ollama, utilizza i seguenti comandi nel terminale. Questi comandi scaricheranno automaticamente il modello se non è già installato:

Per scaricare ed eseguire il modello LLaMA 3.1 di Meta (Facebook):

ollama run llama3.1Per scaricare ed eseguire il modello Gemma 2 di Google:

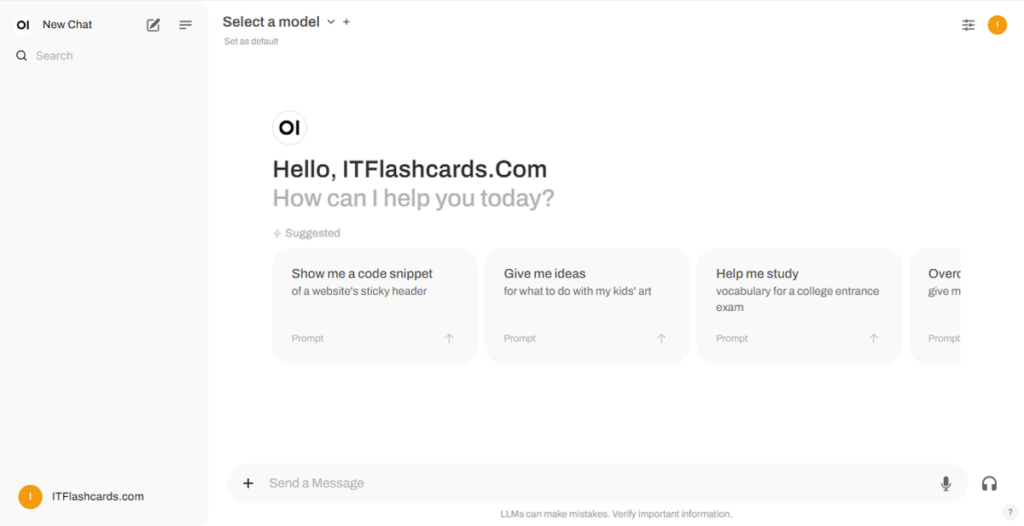

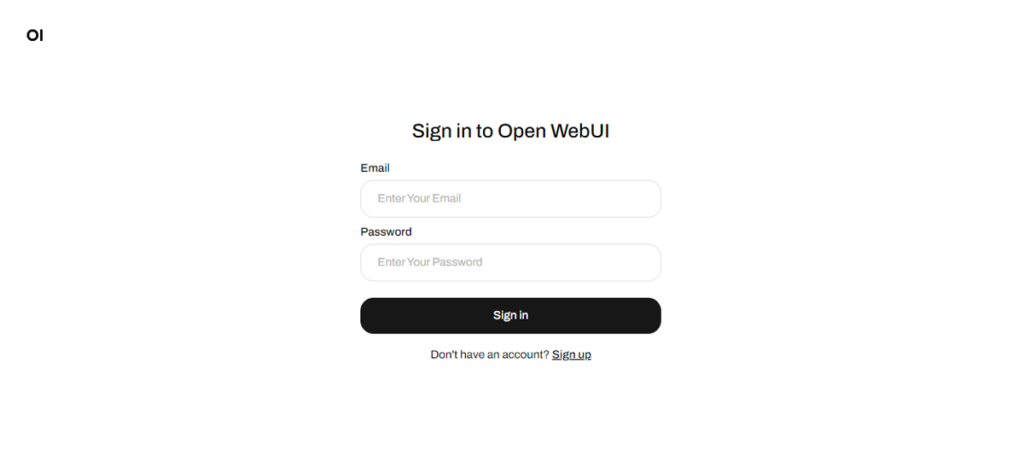

ollama run gemma2Una volta avviato Open WebUI, puoi accedervi tramite http://localhost:8080. Dopo aver navigato a questo indirizzo, ti verrà chiesto di accedere o registrarti. Per creare un nuovo account, seleziona l'opzione Sign Up. Questo account viene creato localmente, il che significa che è disponibile solo su questa macchina e nessun altro utente del tuo sistema avrà accesso ai tuoi dati.

Se hai già avviato Open WebUI e i modelli scaricati tramite Ollama non compaiono nell'elenco, aggiorna la pagina per aggiornare i modelli disponibili. Tutti i dati gestiti all'interno di Open WebUI sono archiviati localmente sul tuo dispositivo, garantendo privacy e controllo sui tuoi modelli e interazioni.

Se desideri installare Open WebUI clonando il progetto da GitHub e gestendolo manualmente, segui questi passaggi:

Apri un terminale e naviga nella directory dove vuoi clonare il repository.

Clona il repository di Open WebUI utilizzando Git:

git clone https://github.com/open-webui/open-webui.gitPassa alla directory del progetto:

cd open-webui/Copia il file .env:

cp -RPp .env.example .envCostruisci il frontend utilizzando Node.js:

npm install

npm run buildPassa nella directory backend:

cd ./backend(Opzionale) Crea e attiva un ambiente Conda:

conda create --name open-webui-env python=3.11

conda activate open-webui-envInstalla le dipendenze Python:

pip install -r requirements.txt -UAvvia l'applicazione:

bash start.shApri un terminale e naviga nella directory in cui vuoi clonare il repository.

Clona il repository di Open WebUI utilizzando Git:

git clone https://github.com/open-webui/open-webui.gitPassa alla directory del progetto:

cd open-webuiCopia il file .env:

copy .env.example .envCostruisci il frontend utilizzando Node.js:

npm install

npm run buildAccedi alla directory del backend:

cd .\backend(Opzionale) Crea e attiva un ambiente Conda:

conda create --name open-webui-env python=3.11

conda activate open-webui-envInstalla le dipendenze Python:

pip install -r requirements.txt -UAvvia l'applicazione:

start_windows.batSeguendo questa guida, dovresti essere in grado di eseguire Ollama e Open WebUI (senza Docker) localmente con successo senza problemi. Tuttavia, se riscontri errori o difficoltà lungo il percorso, lascia un commento e farò del mio meglio per aiutarti.

Ollama + Open WebUI: Un modo per eseguire LLM localmente su Windows, Linux o macOS (senza Docker)