推定読書時間: 1 minute

このガイドでは、Dockerを必要とせずに、Windows、Linux、またはmacOS上でOllamaとOpen WebUIを使用して、大規模言語モデル(LLM)をローカルで簡単に設定して実行する方法を説明します。Ollamaはローカルモデル推論を提供し、Open WebUIはこれらのモデルとの対話を簡素化するユーザーインターフェースです。この体験は、ChatGPT、Google Gemini、Claude AIのインターフェースに似ています。

Dockerを使用せずにOpen WebUIを実行することで、コンピュータのリソースをより効率的に活用できます。コンテナ化された環境の制限がないため、利用可能なシステムメモリ、CPUパワー、およびストレージをすべてアプリケーションの実行に完全に活用することができます。これは、特にリソース集約型のモデルを扱う場合に、パフォーマンスが重要になる場面で役立ちます。

例えば、大規模言語モデルと対話するためにOpen WebUIを使用している場合、ネイティブ実行により処理時間が短縮され、パフォーマンスが向上します。Dockerがコンテナを管理するオーバーヘッドがないためです。ネイティブ実行することで、以下の利点も得られます。

開始する前に、システムに以下がインストールされていることを確認してください。

必ずPython 3.11.Xを使用してください。例えば、バージョン3.11.6がうまく機能します。最新バージョンのPython 3.12.7は、現在のOpen WebUIバージョンと互換性がありません。

Pythonはこちらからダウンロードできます。お使いのオペレーティングシステムに適したバージョンを選択してください。Pythonは、AIや機械学習、特に大規模言語モデル(LLM)の開発と運用に広く使用されている汎用プログラミング言語です。この分野でのスキルを伸ばしたい方は、効率的に学べるPythonフラッシュカードもチェックしてみてください。

Open WebUIをインストールするには、Pythonのパッケージマネージャーpipを使用します。以下の手順に従ってください。

ターミナルを開き、次のコマンドを実行してOpen WebUIをインストールします。

pip install open-webuiインストール後、次のコマンドを実行してpipを最新バージョンに更新します。

python.exe -m pip install --upgrade pipOpen WebUIをインストールした後、次のコマンドでサーバーを起動します。

open-webui serveOpen WebUIの起動に成功すると、ブラウザで次のアドレスにアクセスできます: http://localhost:8080

また、希望する場合は、GitHubからプロジェクトを直接クローンして、Open WebUIをインストールすることもできます。詳細は、このガイドの最後のセクションをご覧ください。

デフォルトでは、Ollamaはシステム上の次のパスに言語モデル(LLM)を保存します。

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\models必要に応じてこのパスを変更できます。例えば、Windowsでは次のコマンドを使用します。

setx OLLAMA_MODELS "D:\ollama_models"macOSアプリケーションとしてOllamaを実行している場合、環境変数はlaunchctlを使用して設定する必要があります。変数を設定するには、次のコマンドを使用します。

launchctl setenv OLLAMA_MODELS "/new/path/to/models"変数を設定した後、変更を適用するためにOllamaアプリケーションを再起動します。

LinuxユーザーがOllamaをsystemdサービスとして実行している場合、systemctlを使用して環境変数を設定できます。設定方法は次の通りです。

次のコマンドを実行して、サービス構成を開きます。

sudo systemctl edit ollama.service[Service]セクションの下に、次の行を追加します。

Environment="OLLAMA_MODELS=/new/path/to/models"ファイルを保存してから、systemdをリロードし、サービスを再起動します。

sudo systemctl daemon-reloadsudo systemctl restart ollamaOllamaで言語モデルをダウンロードして実行するには、ターミナルで次のコマンドを使用します。これらのコマンドは、モデルがインストールされていない場合、自動的にダウンロードします。

Meta(Facebook)からLLaMA 3.1モデルをダウンロードして実行するには:

ollama run llama3.1GoogleからGemma 2モデルをダウンロードして実行するには:

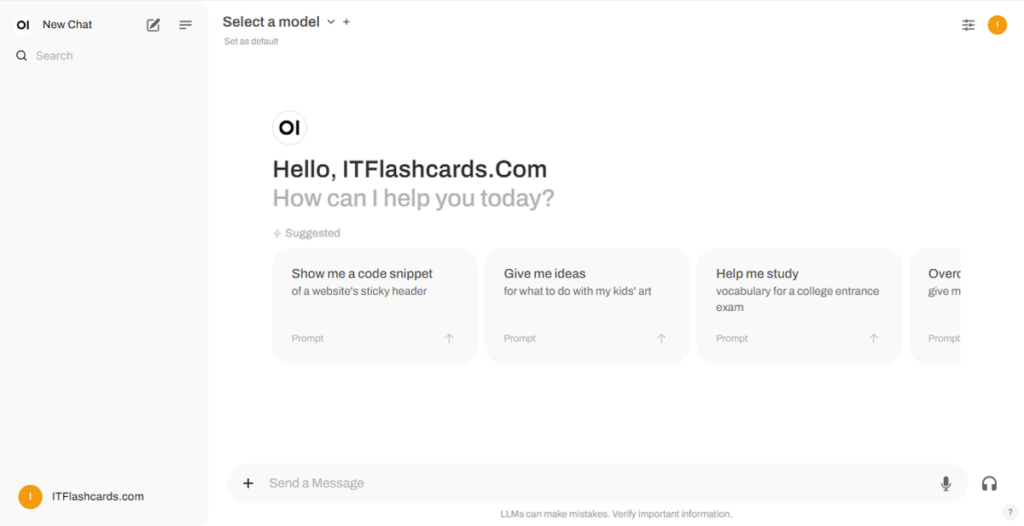

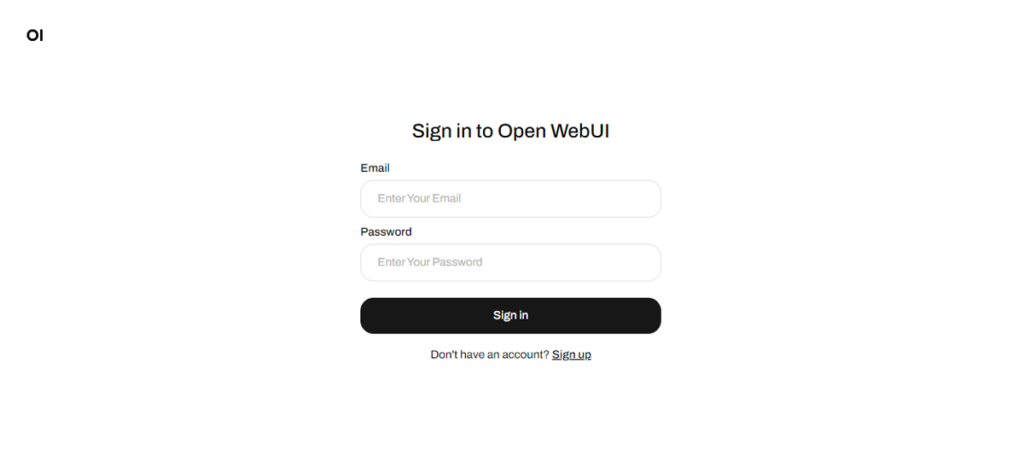

ollama run gemma2Open WebUIが実行されている場合、ブラウザでhttp://localhost:8080にアクセスできます。このアドレスに移動すると、ログインまたは登録を求められます。新しいアカウントを作成するには、サインアップオプションを選択してください。このアカウントはローカルに作成され、他のユーザーがこのシステムであなたのデータにアクセスすることはできません。

Open WebUIを以前に起動しており、Ollamaを介してダウンロードされたモデルがリストに表示されない場合は、ページを更新して利用可能なモデルを更新してください。Open WebUIで管理されるすべてのデータは、デバイス上にローカルに保存されているため、モデルややり取りのプライバシーと管理が保証されます。

GitHubからプロジェクトをクローンして手動で管理することによって、Open WebUIをインストールしたい場合は、以下の手順に従ってください。

ターミナルを開き、リポジトリをクローンしたいディレクトリに移動します。

Gitを使用してOpen WebUIリポジトリをクローンします。

git clone https://github.com/open-webui/open-webui.gitプロジェクトディレクトリに移動します。

cd open-webui/.envファイルをコピーします。

cp -RPp .env.example .envNode.jsを使用してフロントエンドをビルドします。

npm installnpm run buildbackendディレクトリに移動します。

cd ./backend(任意) Conda環境を作成してアクティブ化します。

conda create --name open-webui-env python=3.11conda activate open-webui-envPythonの依存関係をインストールします。

pip install -r requirements.txt -Uアプリケーションを起動します。

bash start.shターミナルを開き、リポジトリをクローンしたいディレクトリに移動します。

Gitを使用してOpen WebUIリポジトリをクローンします。

git clone https://github.com/open-webui/open-webui.gitプロジェクトディレクトリに移動します。

cd open-webui.envファイルをコピーします。

copy .env.example .envNode.jsを使用してフロントエンドをビルドします。

npm installnpm run buildbackendディレクトリに移動します。

cd .\backend(任意) Conda環境を作成してアクティブ化します。

conda create --name open-webui-env python=3.11conda activate open-webui-envPythonの依存関係をインストールします。

pip install -r requirements.txt -Uアプリケーションを起動します。

start_windows.batこのガイドに従うことで、Dockerを使用せずに、OllamaとOpen WebUIをローカルで問題なく実行できるはずです。それでもエラーや問題が発生した場合は、コメントを残していただければ、できる限りサポートいたします。

Ollama + Open WebUI: Windows、Linux、または macOS で LLM をローカルに実行 (Docker 不要)