przez Szymon Bodych

2024-10-03

Szacowany czas czytania: 5 minutes

Ten przewodnik pokaże Ci, jak łatwo skonfigurować i uruchomić duże modele językowe (LLM) lokalnie za pomocą Ollama i Open WebUI na systemach Windows, Linux lub macOS – bez konieczności korzystania z Dockera. Ollama umożliwia lokalne uruchamianie modeli, a Open WebUI to interfejs użytkownika, który upraszcza interakcję z tymi modelami. Doświadczenie jest podobne do korzystania z interfejsów takich jak ChatGPT, Google Gemini czy Claude AI.

Uruchamianie Open WebUI bez Dockera pozwala na bardziej efektywne wykorzystanie zasobów Twojego komputera. Bez ograniczeń związanych z kontenerami wszystkie dostępne zasoby systemowe, takie jak pamięć, moc procesora czy przestrzeń dyskowa, mogą być w pełni wykorzystane do działania aplikacji. Jest to szczególnie ważne podczas pracy z modelami wymagającymi dużych zasobów, gdzie liczy się każda dodatkowa wydajność.

Na przykład, jeśli używasz Open WebUI do pracy z dużymi modelami językowymi, natywne wykonanie może zapewnić szybsze przetwarzanie i płynniejsze działanie, ponieważ nie ma narzutu związanego z zarządzaniem kontenerem przez Dockera. Uruchamianie bezpośrednie daje także:

Zanim zaczniesz, upewnij się, że na Twoim systemie są zainstalowane następujące elementy:

Upewnij się, że korzystasz z wersji Python 3.11.X. Na przykład wersja 3.11.6 działa dobrze. Najnowsza wersja Pythona, 3.12.7, nie jest kompatybilna z aktualną wersją Open WebUI.

Możesz pobrać Pythona tutaj. Upewnij się, że wybierasz odpowiednią wersję dla swojego systemu operacyjnego. Python to wszechstronny język programowania, szeroko stosowany w AI i uczeniu maszynowym, w tym w rozwoju i działaniu dużych modeli językowych (LLM). Jeśli chcesz rozwijać swoje umiejętności w tym obszarze, zapoznaj się z naszymi fiszkami do nauki Pythona, które umożliwią szybką i efektywną naukę.

Aby zainstalować Open WebUI, możesz użyć menedżera pakietów Pythona, pip. Postępuj zgodnie z poniższymi krokami:

Otwórz terminal i uruchom poniższą komendę, aby zainstalować Open WebUI:

pip install open-webuiPo instalacji zaktualizuj pip do najnowszej wersji, wpisując:

python.exe -m pip install --upgrade pipPo zakończeniu instalacji uruchom serwer za pomocą poniższej komendy:

open-webui servePo pomyślnym uruchomieniu Open WebUI, uzyskasz do niego dostęp w przeglądarce pod adresem: http://localhost:8080.

Dodatkowo, jeśli wolisz, możesz zainstalować Open WebUI, klonując projekt bezpośrednio z GitHuba. Szczegóły znajdziesz w sekcji na końcu tego przewodnika.

Domyślnie Ollama ustawia następujące ścieżki do przechowywania modeli językowych (LLM) na Twoim systemie:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsW razie potrzeby możesz zmienić tę ścieżkę. Na przykład, aby zmienić ścieżkę w systemie Windows, użyj następującej komendy:

setx OLLAMA_MODELS "D:\ollama_models"Jeśli uruchamiasz Ollama na macOS jako aplikację, zmienne środowiskowe powinny być ustawiane za pomocą komendy launchctl. Aby ustawić zmienną, użyj następującej komendy:

launchctl setenv OLLAMA_MODELS "/nowa/ścieżka/do/modeli"Po ustawieniu zmiennej uruchom ponownie aplikację Ollama, aby zmiany zaczęły obowiązywać.

Użytkownicy Linuxa, którzy uruchamiają Ollama jako usługę systemd, mogą ustawić zmienne środowiskowe za pomocą systemctl. Oto jak to zrobić:

Otwórz konfigurację usługi za pomocą komendy:

sudo systemctl edit ollama.serviceW sekcji [Service] dodaj następującą linię:

Environment="OLLAMA_MODELS=/new/path/to/models"Zapisz plik, a następnie przeładuj systemd i uruchom ponownie usługę:

sudo systemctl daemon-reload

sudo systemctl restart ollamaAby pobrać i uruchomić modele językowe w Ollama, użyj następujących komend w terminalu. Te komendy automatycznie pobiorą model, jeśli nie jest jeszcze zainstalowany:

Aby pobrać i uruchomić model LLaMA 3.1 od Meta (Facebook):

ollama run llama3.1Aby pobrać i uruchomić model Gemma 2 od Google:

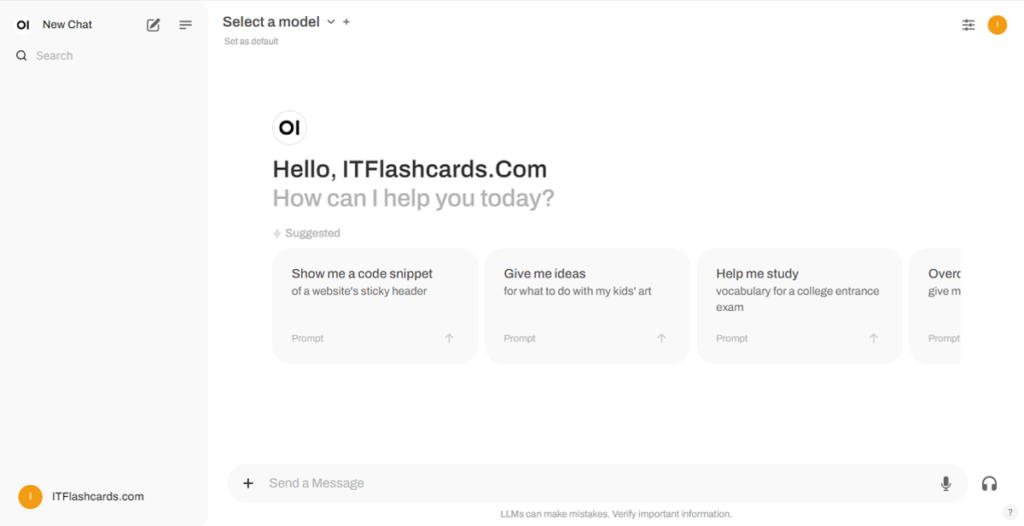

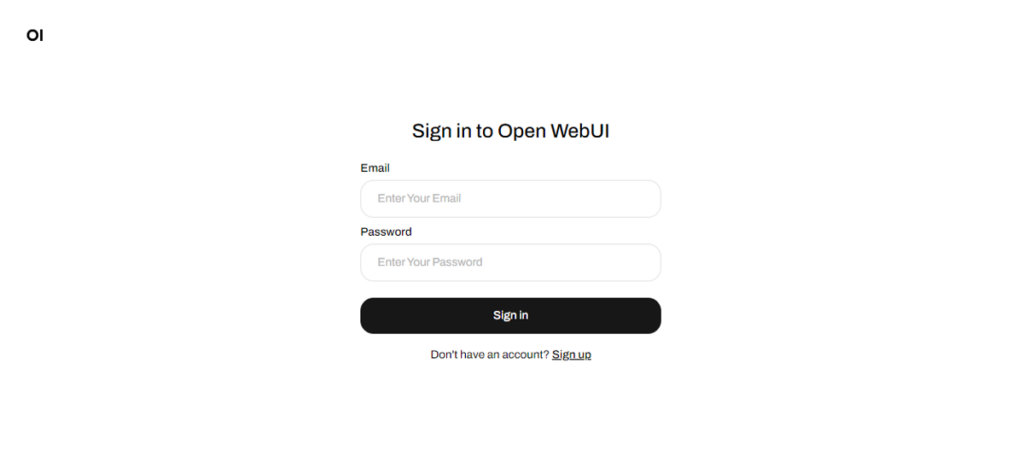

ollama run gemma2Po uruchomieniu Open WebUI możesz uzyskać do niego dostęp, wchodząc na http://localhost:8080. Po przejściu na tę stronę zostaniesz poproszony o zalogowanie się lub rejestrację. Aby utworzyć nowe konto, wybierz opcję Zarejestruj się. To konto jest tworzone lokalnie, co oznacza, że jest dostępne tylko na tym komputerze, a inni użytkownicy systemu nie mają dostępu do Twoich danych.

Jeśli wcześniej uruchomiłeś Open WebUI, a modele nie pojawiają się na liście, odśwież stronę, aby zaktualizować dostępne modele. Wszystkie dane zarządzane w ramach Open WebUI są przechowywane lokalnie na Twoim urządzeniu, co zapewnia prywatność i pełną kontrolę nad modelami i interakcjami.

Jeśli wolisz zainstalować Open WebUI, klonując projekt z GitHuba i zarządzając nim ręcznie, postępuj zgodnie z poniższymi krokami:

Otwórz terminal i przejdź do katalogu, w którym chcesz sklonować repozytorium.

Sklonuj repozytorium Open WebUI za pomocą Gita:

git clone https://github.com/open-webui/open-webui.gitPrzejdź do katalogu projektu:

cd open-webui/Skopiuj plik .env:

cp -RPp .env.example .envZbuduj frontend za pomocą Node.js:

npm install

npm run buildPrzejdź do katalogu backend:

cd .\backend(Opcjonalnie) Utwórz i aktywuj środowisko Conda:

conda create --name open-webui-env python=3.11

conda activate open-webui-envZainstaluj zależności Pythona:

pip install -r requirements.txt -UUruchom aplikację:

bash start.shOtwórz terminal i przejdź do katalogu, w którym chcesz sklonować repozytorium.

Sklonuj repozytorium Open WebUI za pomocą Gita:

git clone https://github.com/open-webui/open-webui.gitPrzejdź do katalogu projektu:

cd open-webuiSkopiuj plik .env:

copy .env.example .envZbuduj frontend za pomocą Node.js:

npm install

npm run buildPrzejdź do katalogu backend:

cd .\backend(Opcjonalnie) Utwórz i aktywuj środowisko Conda:

conda create --name open-webui-env python=3.11

conda activate open-webui-envZainstaluj zależności Pythona:

pip install -r requirements.txt -UUruchom aplikację:

start_windows.batPostępując zgodnie z tym przewodnikiem, powinieneś być w stanie uruchomić Ollama i Open WebUI (bez Dockera) lokalnie bez żadnych problemów. Jeśli jednak napotkasz jakiekolwiek błędy lub trudności, zostaw komentarz, a postaram się pomóc.

Ollama + Open WebUI: Uruchom LLM lokalnie na Windows, Linux lub macOS (bez Dockera)