2024-12-04

Предполагаемое время чтения: 5 минут

Это руководство покажет вам, как легко настроить и запустить крупные языковые модели (LLM) локально с использованием Ollama и Open WebUI на Windows, Linux или macOS — без необходимости в Docker. Ollama обеспечивает локальную обработку моделей, а Open WebUI предоставляет удобный интерфейс для взаимодействия с этими моделями. Это похоже на использование интерфейсов, таких как ChatGPT, Google Gemini или Claude AI.

Запуск Open WebUI без Docker позволяет более эффективно использовать ресурсы вашего компьютера. Без ограничений контейнеризированных сред вся доступная оперативная память, мощность процессора и хранилище могут быть полностью использованы для работы приложения. Это особенно важно при работе с ресурсоемкими моделями, где важна каждая деталь производительности.

Например, если вы используете Open WebUI для взаимодействия с крупными языковыми моделями, нативное выполнение может привести к более быстрому времени обработки и более плавной работе, так как отсутствует накладные расходы на управление контейнером. При нативной работе вы также получаете:

Перед началом убедитесь, что у вас установлены следующие компоненты:

Убедитесь, что вы используете Python 3.11.X. Например, версия 3.11.6 работает хорошо. Последняя версия Python, 3.12.7, не совместима с текущей версией Open WebUI.

Вы можете скачать Python здесь. Убедитесь, что вы выбрали подходящую версию для вашей операционной системы. Python — универсальный язык программирования, широко используемый в области ИИ и машинного обучения, включая разработку и эксплуатацию крупных языковых моделей (LLM). Если вы хотите улучшить свои навыки в этой области, обязательно ознакомьтесь с нашими карточками Python для быстрого и эффективного обучения.

Для установки Open WebUI вы можете использовать менеджер пакетов Python pip. Следуйте этим шагам:

Откройте терминал и выполните следующую команду для установки Open WebUI:

pip install open-webuiПосле установки обновите pip до последней версии, выполнив:

python.exe -m pip install --upgrade pipПосле установки Open WebUI запустите сервер с помощью следующей команды:

open-webui serveПосле успешного запуска Open WebUI вы можете получить к нему доступ в вашем браузере по адресу: http://localhost:8080.

Кроме того, если вы предпочитаете, вы можете установить Open WebUI, клонировав проект напрямую из GitHub. Более подробную информацию смотрите в конце этого руководства.

По умолчанию Ollama использует следующие пути для хранения языковых моделей (LLM) на вашей системе:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsВы можете изменить этот путь, если это необходимо. Например, на Windows используйте следующую команду:

setx OLLAMA_MODELS "D:\ollama_models"Если вы используете Ollama как приложение на macOS, переменные среды необходимо задавать с помощью команды launchctl. Для установки переменной используйте следующую команду:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"После установки переменной перезапустите приложение Ollama, чтобы изменения вступили в силу.

Для пользователей Linux, работающих с Ollama как с сервисом systemd, переменные среды можно настроить с помощью systemctl. Вот как это сделать:

Откройте конфигурацию сервиса, выполнив команду:

sudo systemctl edit ollama.serviceВ разделе [Service] добавьте следующую строку:

Environment="OLLAMA_MODELS=/new/path/to/models"Сохраните файл, затем перезагрузите systemd и перезапустите сервис:

sudo systemctl daemon-reload

sudo systemctl restart ollamaДля загрузки и запуска языковых моделей в Ollama используйте следующие команды в терминале. Эти команды автоматически загрузят модель, если она еще не установлена:

Для загрузки и запуска модели LLaMA 3.1 от Meta (Facebook):

ollama run llama3.1Для загрузки и запуска модели Gemma 2 от Google:

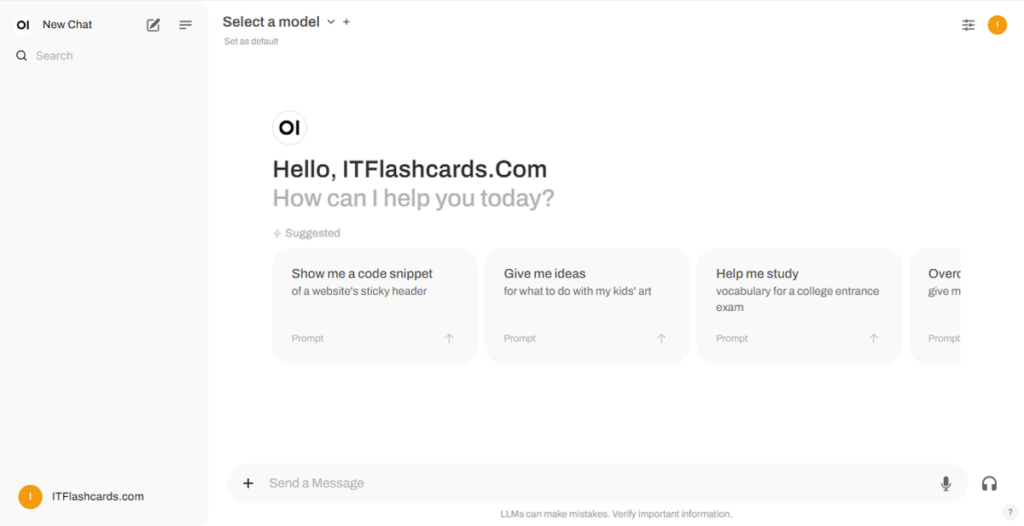

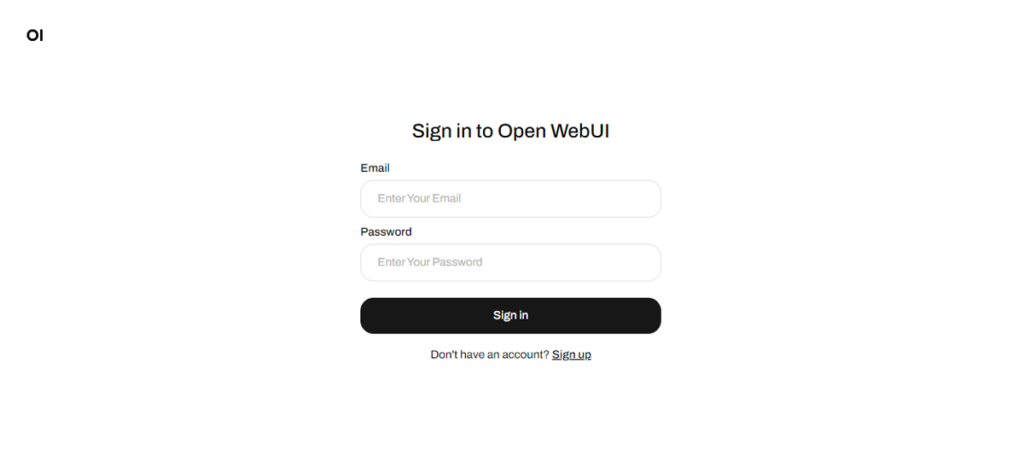

ollama run gemma2После запуска Open WebUI вы можете получить к нему доступ по адресу http://localhost:8080. Перейдя по этому адресу, вы будете приглашены зарегистрироваться или войти в систему. Чтобы создать новый аккаунт, выберите опцию "Sign Up". Этот аккаунт создается локально, то есть он доступен только на этом устройстве, и никакой другой пользователь не сможет получить доступ к вашим данным.

Если вы ранее запускали Open WebUI, но загруженные через Ollama модели не отображаются в списке, обновите страницу, чтобы обновить доступные модели. Все данные, управляемые в Open WebUI, хранятся локально на вашем устройстве, что обеспечивает конфиденциальность и контроль над вашими моделями и взаимодействиями.

Если вы хотите установить Open WebUI, клонировав проект с GitHub и управляя им вручную, выполните следующие действия:

Откройте терминал и перейдите в каталог, куда вы хотите клонировать репозиторий.

Клонируйте репозиторий Open WebUI с помощью Git:

git clone https://github.com/open-webui/open-webui.gitПерейдите в каталог проекта:

cd open-webuiСкопируйте файл .env:

copy .env.example .envСоберите интерфейс с помощью Node.js:

npm install

npm run buildПерейдите в каталог backend:

cd .\backend(Опционально) Создайте и активируйте окружение Conda:

conda create --name open-webui-env python=3.11

conda activate open-webui-envУстановите зависимости Python:

pip install -r requirements.txt -UЗапустите приложение:

start_windows.batСледуя этому руководству, вы сможете успешно запустить Ollama и Open WebUI (без Docker) локально без каких-либо проблем. Однако, если у вас возникнут ошибки или трудности, оставьте комментарий, и я постараюсь вам помочь.

Ollama + Open WebUI: Способ локального запуска LLM на Windows, Linux или macOS (без Docker)