від Szymon Bodych

2024-10-08

Орієнтовний час читання: 5 minutes

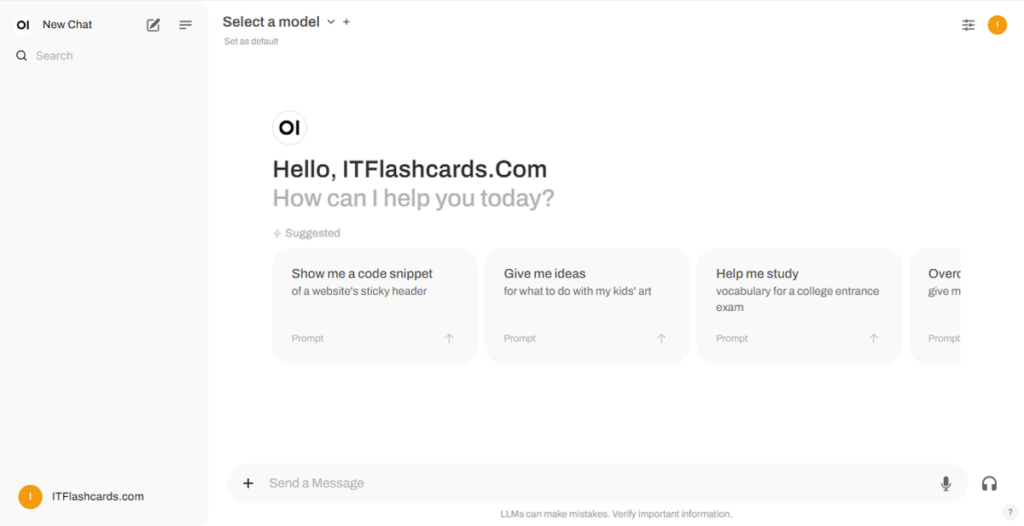

Цей посібник покаже вам, як легко налаштувати та запустити великі мовні моделі (LLM) локально за допомогою Ollama та Open WebUI на Windows, Linux або macOS – без необхідності використовувати Docker. Ollama забезпечує локальне прогнозування моделей, а Open WebUI є інтерфейсом користувача, що спрощує взаємодію з цими моделями. Досвід є подібним до використання інтерфейсів, таких як ChatGPT, Google Gemini або Claude AI.

Запуск Open WebUI без Docker дозволяє ефективніше використовувати ресурси вашого комп’ютера. Без обмежень контейнеризованих середовищ усі доступні системні ресурси, такі як оперативна пам’ять, потужність процесора та зберігання, можуть бути повністю присвячені роботі з додатком. Це особливо важливо під час роботи з моделями, що потребують великих ресурсів, де кожна частинка продуктивності має значення.

Наприклад, якщо ви використовуєте Open WebUI для взаємодії з великими мовними моделями, нативне виконання може призвести до швидшої обробки та більш плавної роботи, оскільки немає перевантаження через Docker, що керує контейнером. Запускаючи нативно, ви також отримуєте такі переваги:

Перед початком переконайтеся, що на вашій системі встановлено наступне:

Переконайтеся, що ви використовуєте Python 3.11.X. Наприклад, версія 3.11.6 працює добре. Остання версія Python, 3.12.7, несумісна з поточною версією Open WebUI.

Завантажити Python можна тут. Обов’язково виберіть відповідну версію для вашої операційної системи. Python — це універсальна мова програмування, широко використовувана в галузі штучного інтелекту та машинного навчання, включаючи розробку та експлуатацію великих мовних моделей (LLM). Якщо ви хочете розвивати свої навички в цій галузі, обов’язково перегляньте наші картки з Python для швидкого та ефективного навчання.

Щоб встановити Open WebUI, ви можете скористатися менеджером пакетів Python pip. Виконайте ці кроки:

Відкрийте свій термінал і виконайте наступну команду для встановлення Open WebUI:

pip install open-webuiПісля встановлення оновіть pip до останньої версії, виконавши наступну команду:

python.exe -m pip install --upgrade pipПісля встановлення Open WebUI запустіть сервер за допомогою наступної команди:

open-webui serveПісля успішного запуску Open WebUI ви зможете отримати доступ до нього через свій браузер за адресою: http://localhost:8080.

За замовчуванням Ollama встановлює наступні шляхи для зберігання мовних моделей (LLM) на вашій системі:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsВи можете змінити цей шлях за необхідності. Наприклад, на Windows скористайтеся наступною командою:

setx OLLAMA_MODELS "D:\ollama_models"Якщо ви запускаєте Ollama як додаток macOS, змінні середовища повинні бути встановлені за допомогою launchctl. Щоб встановити змінну, скористайтеся наступною командою:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Після встановлення змінної перезапустіть додаток Ollama, щоб зміни набули чинності.

Для користувачів Linux, які запускають Ollama як службу systemd, ви можете налаштувати змінні середовища за допомогою systemctl. Ось як це зробити:

Відкрийте конфігурацію служби, виконавши:

sudo systemctl edit ollama.serviceУ розділі [Service] додайте наступний рядок:

Environment="OLLAMA_MODELS=/new/path/to/models"Збережіть файл, після чого перезавантажте systemd і перезапустіть службу:

sudo systemctl daemon-reloadsudo systemctl restart ollamaЩоб завантажити та запустити мовні моделі в Ollama, скористайтеся наступними командами в терміналі. Ці команди автоматично завантажать модель, якщо вона ще не встановлена:

Щоб завантажити та запустити модель LLaMA 3.1 від Meta (Facebook):

ollama run llama3.1Щоб завантажити та запустити модель Gemma 2 від Google:

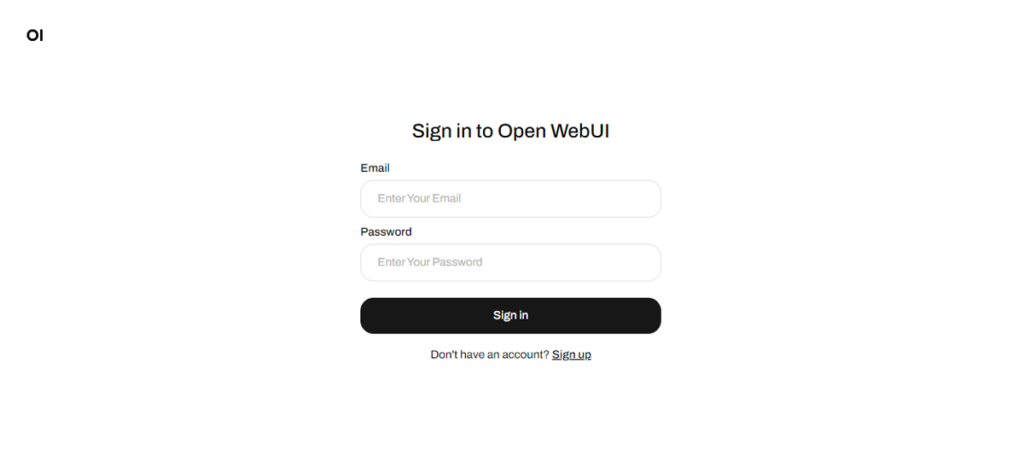

ollama run gemma2Після запуску Open WebUI ви зможете отримати доступ до нього через http://localhost:8080. Після переходу за цією адресою вам буде запропоновано увійти або зареєструватися. Щоб створити новий обліковий запис, виберіть опцію «Зареєструватися». Цей обліковий запис створюється локально, тобто він доступний лише на цьому комп’ютері, і жоден інший користувач вашої системи не матиме доступу до ваших даних.

Якщо ви раніше запускали Open WebUI і моделі, завантажені через Ollama, не відображаються в списку, оновіть сторінку, щоб оновити доступні моделі. Усі дані, якими керує Open WebUI, зберігаються локально на вашому пристрої, що гарантує конфіденційність і контроль над вашими моделями та взаємодіями.

Якщо ви хочете встановити Open WebUI шляхом клонування проекту з GitHub і керування ним вручну, виконайте такі дії:

Відкрийте термінал і перейдіть до каталогу, куди ви хочете клонувати репозиторій.

Клонуйте репозиторій Open WebUI за допомогою Git:

git clone https://github.com/open-webui/open-webui.gitПерейдіть до каталогу проекту:

cd open-webui/Скопіюйте файл .env:

cp -RPp .env.example .envЗберіть фронтенд за допомогою Node.js:

npm installnpm run buildПерейдіть до каталогу backend:

cd ./backend(Необов’язково) Створіть і активуйте середовище Conda:

conda create --name open-webui-env python=3.11conda activate open-webui-envВстановіть залежності Python:

pip install -r requirements.txt -UЗапустіть додаток:

bash start.shВідкрийте термінал і перейдіть до каталогу, куди ви хочете клонувати репозиторій.

Клонуйте репозиторій Open WebUI за допомогою Git:

git clone https://github.com/open-webui/open-webui.gitПерейдіть до каталогу проекту:

cd open-webuiСкопіюйте файл .env:

copy .env.example .envЗберіть фронтенд за допомогою Node.js:

npm installnpm run buildПерейдіть до каталогу backend:

cd .\backend(Необов’язково) Створіть і активуйте середовище Conda:

conda create --name open-webui-env python=3.11conda activate open-webui-envВстановіть залежності Python:

pip install -r requirements.txt -UЗапустіть додаток:

start_windows.batСкориставшись цим посібником, ви зможете успішно запустити Ollama та Open WebUI (без Docker) локально без будь-яких проблем. Однак, якщо ви зіткнетеся з помилками або труднощами на шляху, залиште коментар, і я зроблю все можливе, щоб вам допомогти.

Ollama + Open WebUI: Спосіб локального запуску LLM на Windows, Linux або macOS (без Docker)